【求助帖】关于微调后的大模型如何评估? #164

Labels

No Label

bug

duplicate

enhancement

help wanted

invalid

question

wontfix

No Milestone

No project

No Assignees

3 Participants

Notifications

Due Date

No due date set.

Dependencies

No dependencies set.

Reference: HswOAuth/llm_course#164

Loading…

Reference in New Issue

Block a user

No description provided.

Delete Branch "%!s()"

Deleting a branch is permanent. Although the deleted branch may continue to exist for a short time before it actually gets removed, it CANNOT be undone in most cases. Continue?

我们已经讲解了大模型的微调技术,在实际使用过程中,微调后的效果如何评估?使用哪些工具?希望老师指导一下,或者给一些方向。

可以根据训练任务的要求在模型输出的内容上进行对比评估。

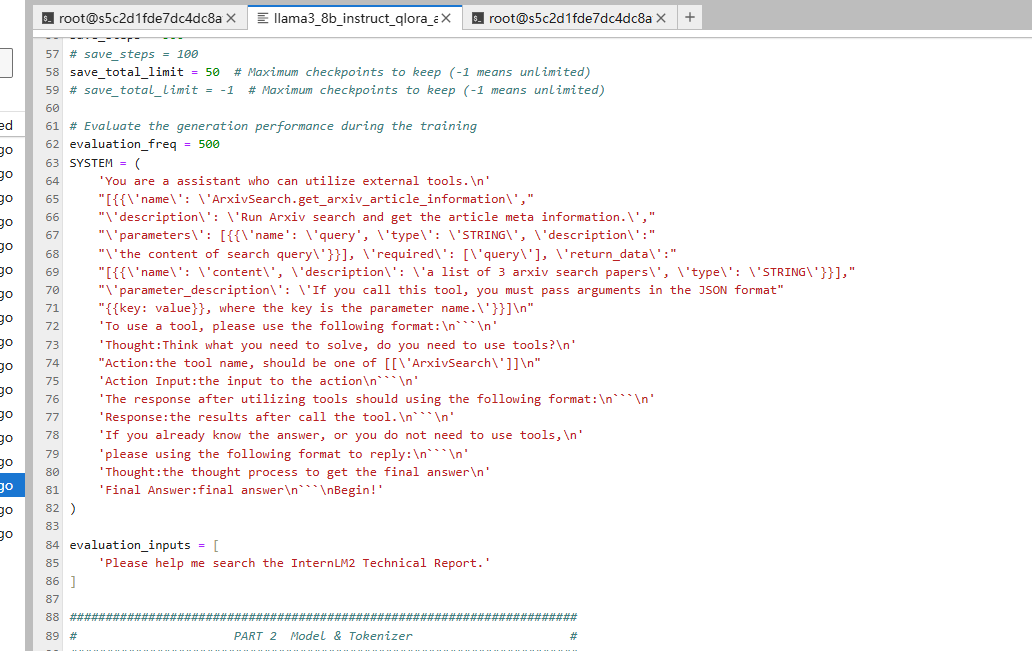

具体来说,对于上次Function Call实践课程中的模型,我们在训练微调时给出的提示词要求是这样的:

可以看到我们在输出格式和参数格式给出了要求:

翻译过来是,如果使用了这个工具就必须将参数用jason格式传递。

后面一大块则是调用时需要说出的一堆格式上的要求。

此外,在测试文件中,我们可以看到在eval_prompt(我理解的是微调提示词)中的Action部分需要给出tools的名字和输入。此时的输入应该是jason格式(function call中函数的输入都应该是这个格式)。

对于测试后的结果可以看出微调后的模型,可以正确给出json格式function参数。

而没有经过微调的就不行。

此外,经过微调后的模型在thought和action等方面的输出也比微调前的更为清楚、详细。

至于如何对准确性和质量在数量上或者更为专业的方式进行评估我也不知道,我只知道这个。

如果自己有比较多的数据用于评估,可以使用OpenCompass工具:https://github.com/open-compass/OpenCompass/

使用指南在这里:https://opencompass.org.cn/doc