ollama并发问题 #166

Labels

No Label

bug

duplicate

enhancement

help wanted

invalid

question

wontfix

No Milestone

No project

No Assignees

2 Participants

Notifications

Due Date

No due date set.

Dependencies

No dependencies set.

Reference: HswOAuth/llm_course#166

Loading…

Reference in New Issue

Block a user

No description provided.

Delete Branch "%!s()"

Deleting a branch is permanent. Although the deleted branch may continue to exist for a short time before it actually gets removed, it CANNOT be undone in most cases. Continue?

gpu:A100 80g 单卡使用 ,参数 OLLAMA_NUM_PARALLEL=100 未生效,希望老师给些建议 关于模型并发请求问题。

docker run -d --runtime nvidia --gpus="device=3" -e OLLAMA_KEEP_ALIVE=24h -e OLLAMA_NUM_PARALLEL=100 -v /data1/LLM_model/ollama1:/root/.ollama -p 9201:11434 --name ollama9201 ollama/ollama:latest

我这边简单测试了下,用的两块3090,看起来并发是没啥问题的

我的docker 镜像id:1577d5e882da

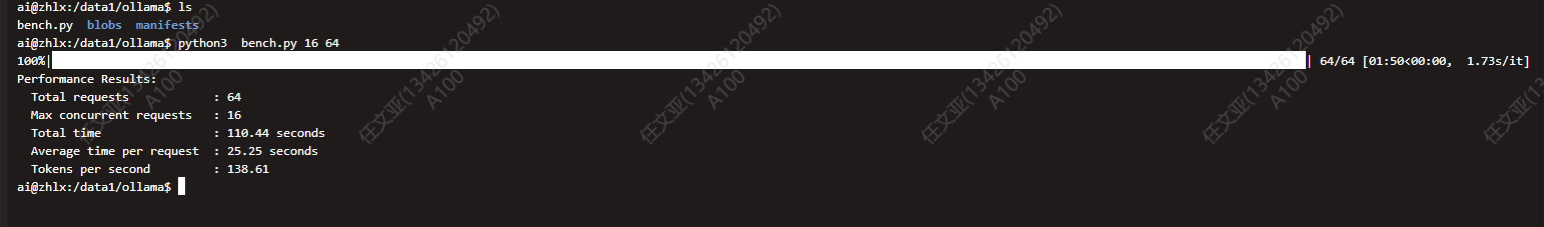

我通过这个脚本压测 结果 如上图。 138token/s 是否正常。

结果 如上图。 138token/s 是否正常。

这个得看用的模型大小和使用的GPU型号了。

138token/s基本能够正常使用了,算是比较快的。

如果只是看并发是不是生效,可以打开两个终端,同时推理同一个模型,看看是不是可以同时输出内容。