【分享及作业】AnythingLLM+Ollama效果 #60

Labels

No Label

bug

duplicate

enhancement

help wanted

invalid

question

wontfix

No Milestone

No project

No Assignees

1 Participants

Notifications

Due Date

No due date set.

Dependencies

No dependencies set.

Reference: HswOAuth/llm_course#60

Loading…

Reference in New Issue

Block a user

No description provided.

Delete Branch "%!s()"

Deleting a branch is permanent. Although the deleted branch may continue to exist for a short time before it actually gets removed, it CANNOT be undone in most cases. Continue?

北京-刘洋-H群

安装

环境使用的是Ubuntu,安装方式是docker安装,好处是不影响本地其他软件的环境

网页访问及初次使用设置

http://127.0.0.1:3010(从其他机器访问http://<Ubuntu机器的IP地址>:3010)等Ollama安装完再正式设置,这里可以随便设置下,之后还可以调整配置

可以跳过

安装Ollama

Ubuntu安装Ollama很简单,运行如下脚本

curl -fsSL https://ollama.com/install.sh | shOllama上下载模型

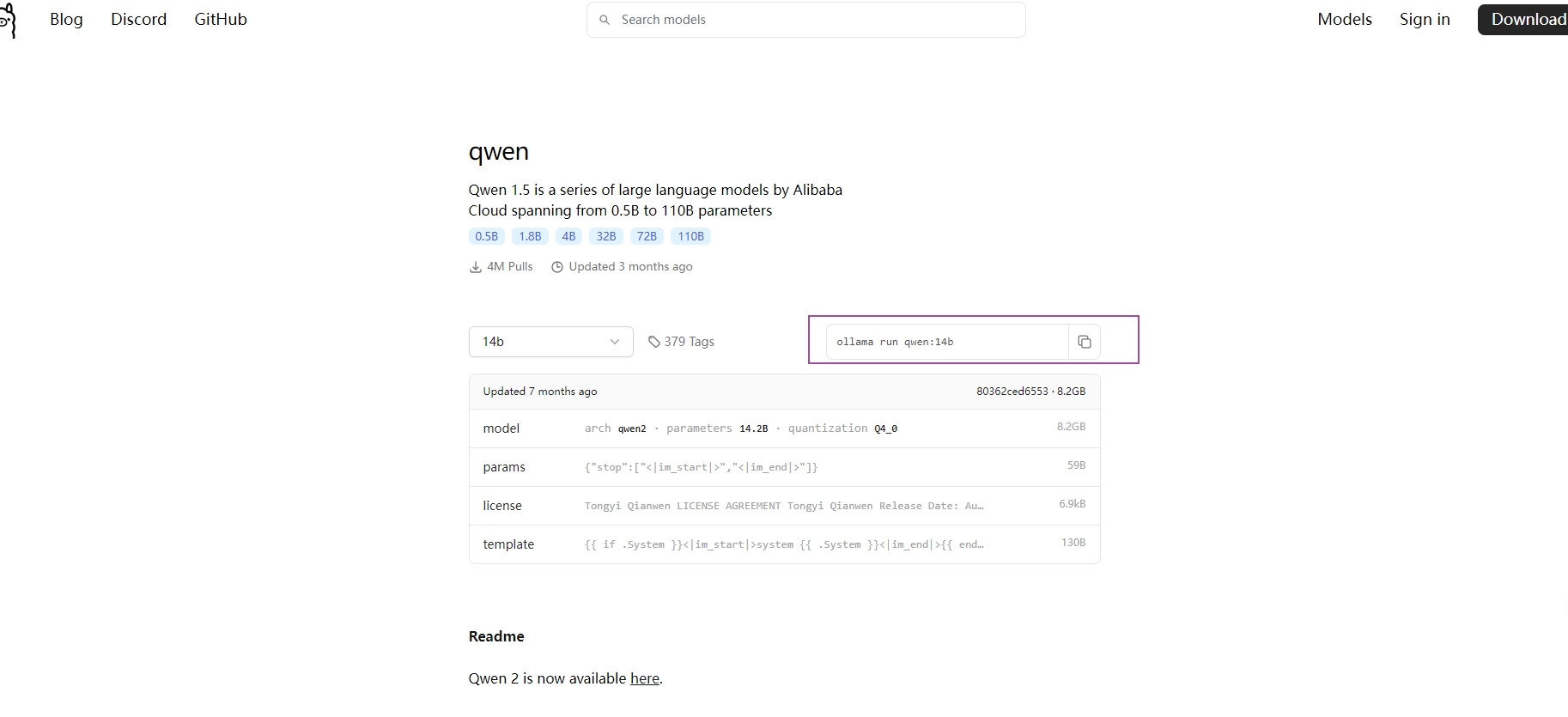

Ollama官网搜索想要的模型(搜不到就可能是ollama暂不支持)

copy 命令 ollama run +模型名称

Ollama 运行模型测试

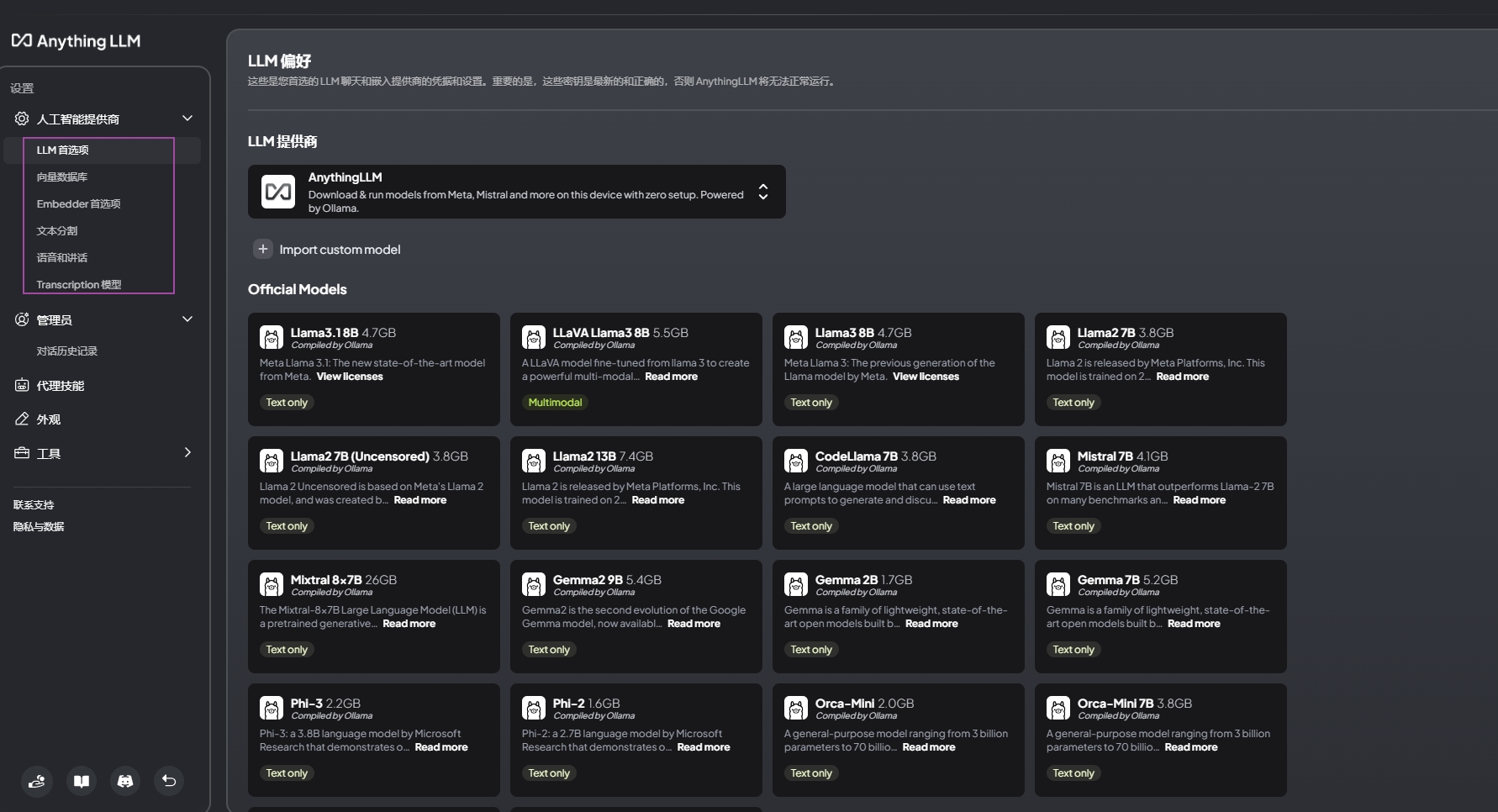

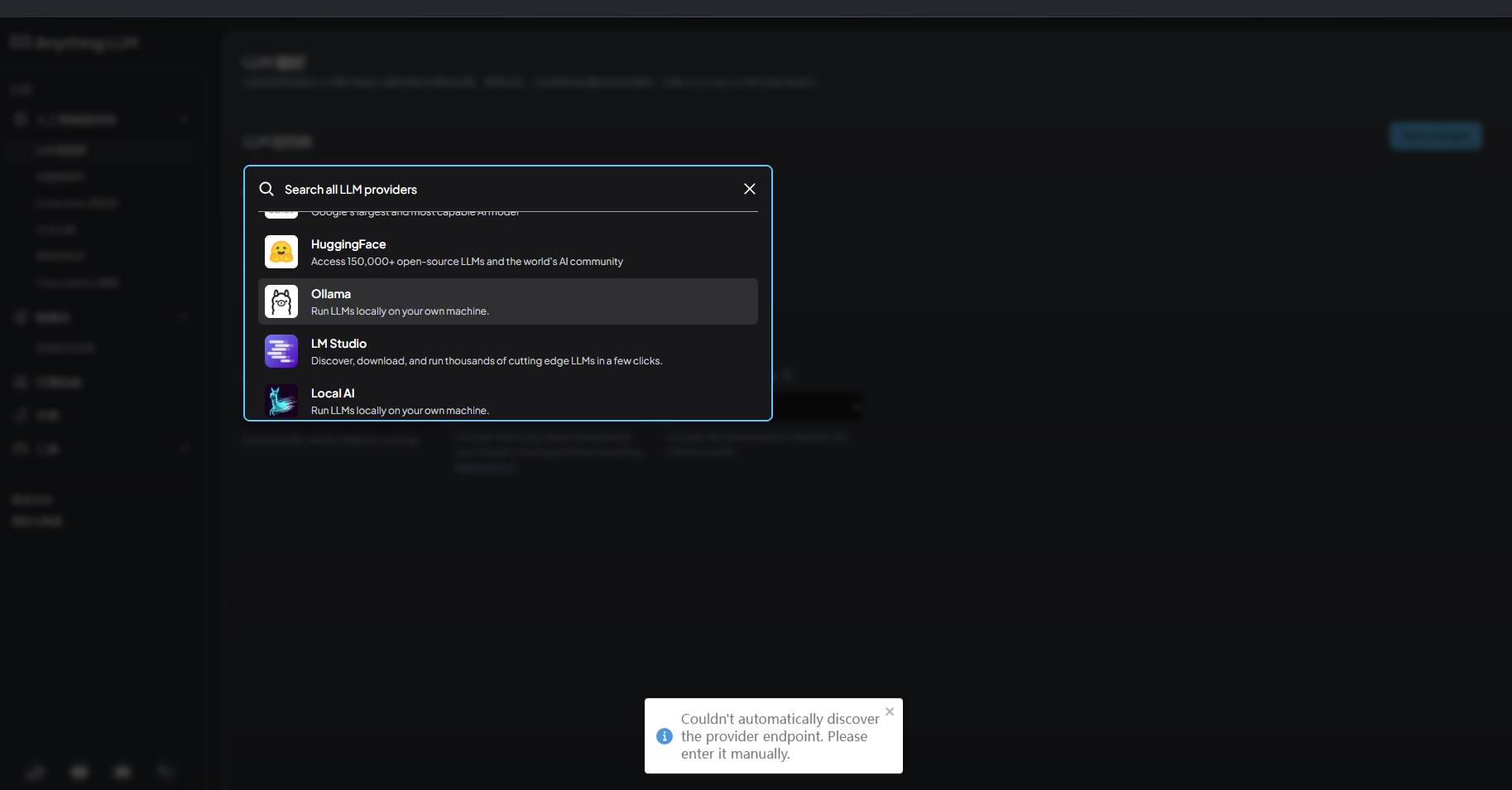

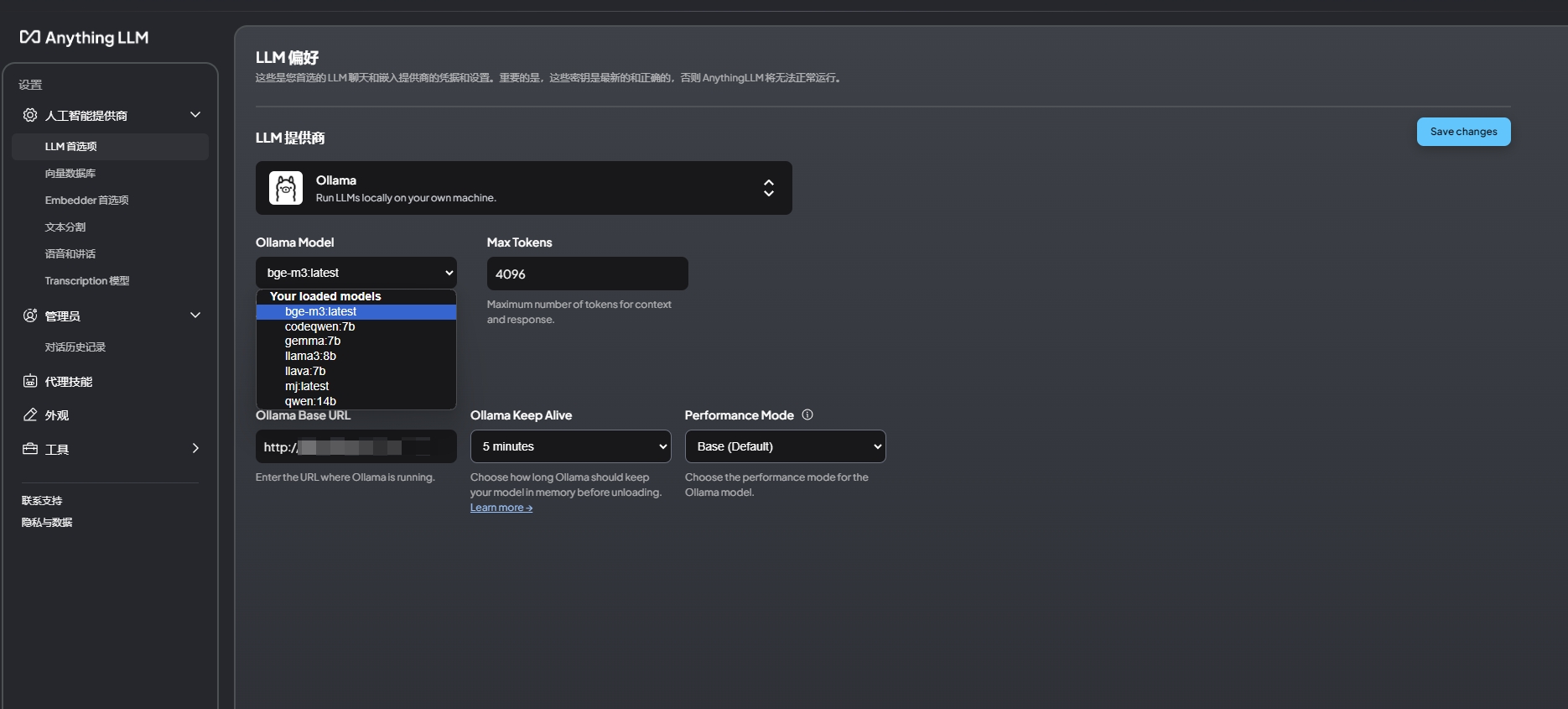

配置anythingLLM接入

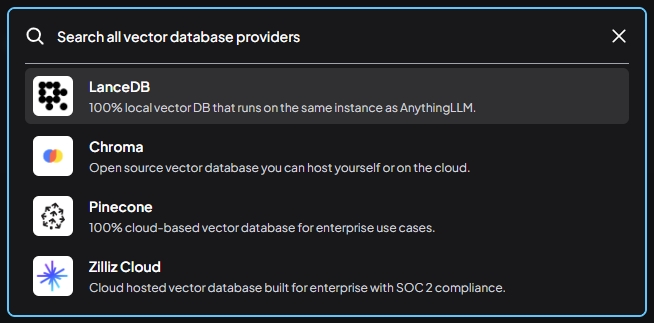

在这里可以设置选择向量模型、对话模型、向量数据库

注:向量模型部分在接入Ollama中的bge-m3模型后读取文档时会有报错,后来就改成了内置的向量模型,数据库也使用的内置的

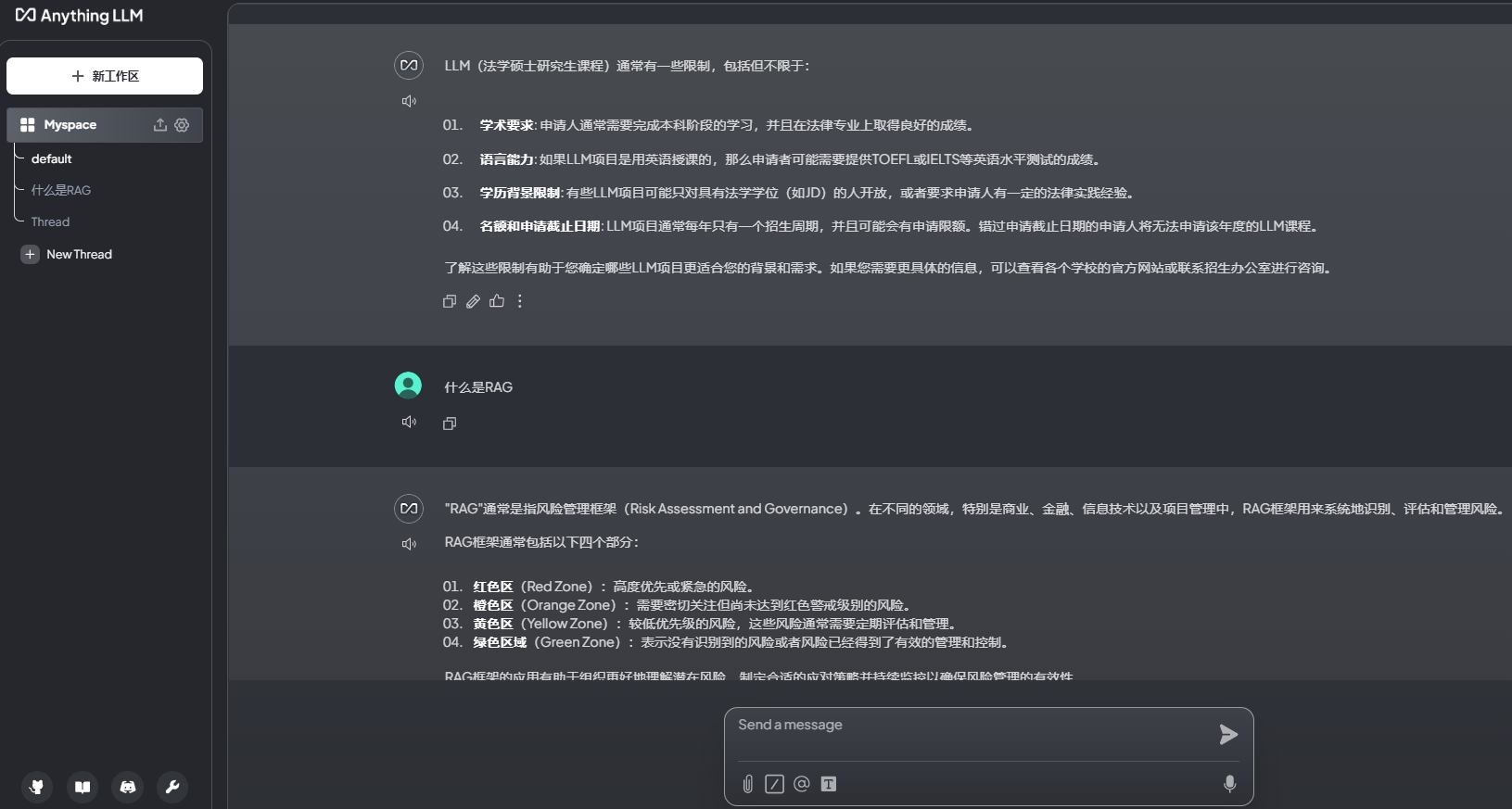

没有使用知识库时的问答测试

回答的明显不是想要

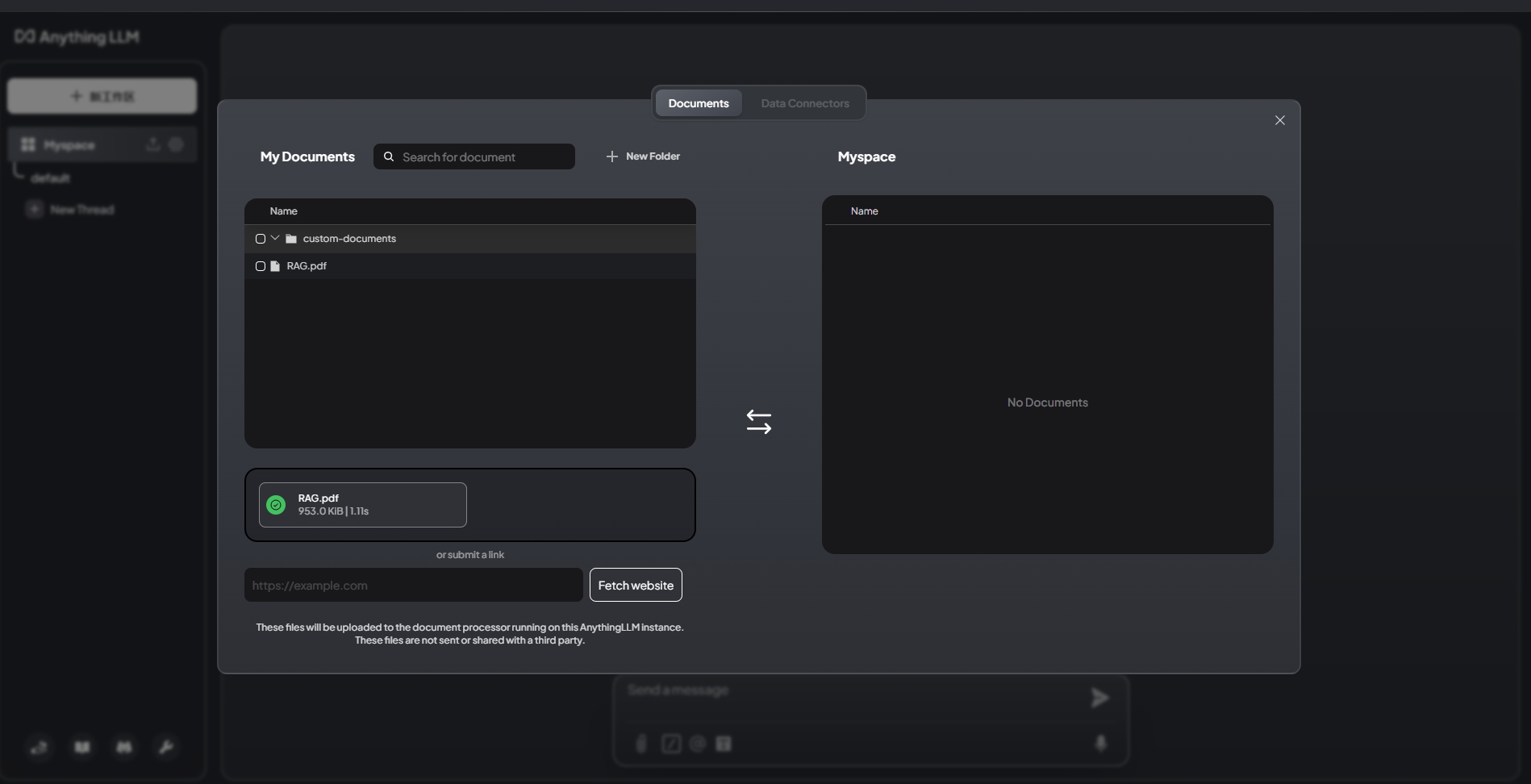

上传文件问答测试

上传一份先知大佬的RAG讲义

分享

除了AnythingLLM还有fastgpt、MaxKB等开源知识也可以配合Ollama或是其他模型API使用,

例外Ollama + OpenwebUI也是一个不错的搭配。

最后,很用心写的帖子,跪求机时。

【分享】AnythingLLM+Ollama效果to 【分享及作业】AnythingLLM+Ollama效果