【求助帖】20250207,大模型初探- 基于LLaMA-Factory的模型微调 #609

Labels

No Label

bug

duplicate

enhancement

help wanted

invalid

question

wontfix

No Milestone

No project

No Assignees

2 Participants

Notifications

Due Date

No due date set.

Dependencies

No dependencies set.

Reference: HswOAuth/llm_course#609

Loading…

Reference in New Issue

Block a user

No description provided.

Delete Branch "%!s()"

Deleting a branch is permanent. Although the deleted branch may continue to exist for a short time before it actually gets removed, it CANNOT be undone in most cases. Continue?

加载 GLM-4-9B-Chat 后,

到测试模型这步都没问题。

【问题1】:用户发问题的时候,回复非常慢。

【问题2】:训练的时候,显示显存不够

大概加载checkpoint到这里就达到极限了

报错 OOM,RuntimeError: RuntimeError: CUDA out of memory. Tried to allocate 214.00 MiB (GPU 0; 23.70 GiB total capacity; 21.60 GiB already allocated; 59.00 MiB free; 21.63 GiB reserved in total by PyTorch) If reserved memory is >> allocated memory try setting max_split_size_mb to avoid fragmentation. See documentation for Memory Management and PYTORCH_CUDA_ALLOC_CONF

但是我看老师也是用的24GB总显存也是可以训练,想请问,是为什么我显存不够?

已经尝试 epoch 调成1,batch size也调小了,数据量从80条数据也减半了,还是不行。想问问应该怎么做呢?

换了一个 1.8B 的Qwen模型,

加载成功原模型【Qwen-1.8B-Chat】后,测试模型出现问题

报错这个,

还是一直解决不了,请求帮助

可以在命令行,输入nvidia-smi查看是否还有其他进程占用显存

没有其他进程占用,我有附上watch nvidia-smi的截图,只有当前进程占用

看看点击“卸载”模型后,显存有没有下降?

有的哦老师,真的没其他任务在占用的显存的,我不明白为什么同样 24G显存,9B我微调不了 checkpoint都没加载完 ,跟着老师相同的步骤相同的模型参数,相同的显存。

老师,我有个请求,可以远程帮忙看看和解答吗?麻烦了

主要是这个问题我问了一周,三天回一次,还没解决到问题,学习进度很慢呢,谢谢帮助~

建议换一台机器试试看。怀疑是显卡的问题。

换了两台服务器的显卡都是这个问题哦,怎么检查是什么问题,希望远程帮助排查问题

麻烦全程录屏,我这边可以把你仔细检查操作流程。

我这边新出现一个报错,(原本没有这个报错的)没成功解决这个报错,可以帮我看看吗?谢谢

麻烦运行下面的命令:pip freeze > requirements_output.txt,然后把

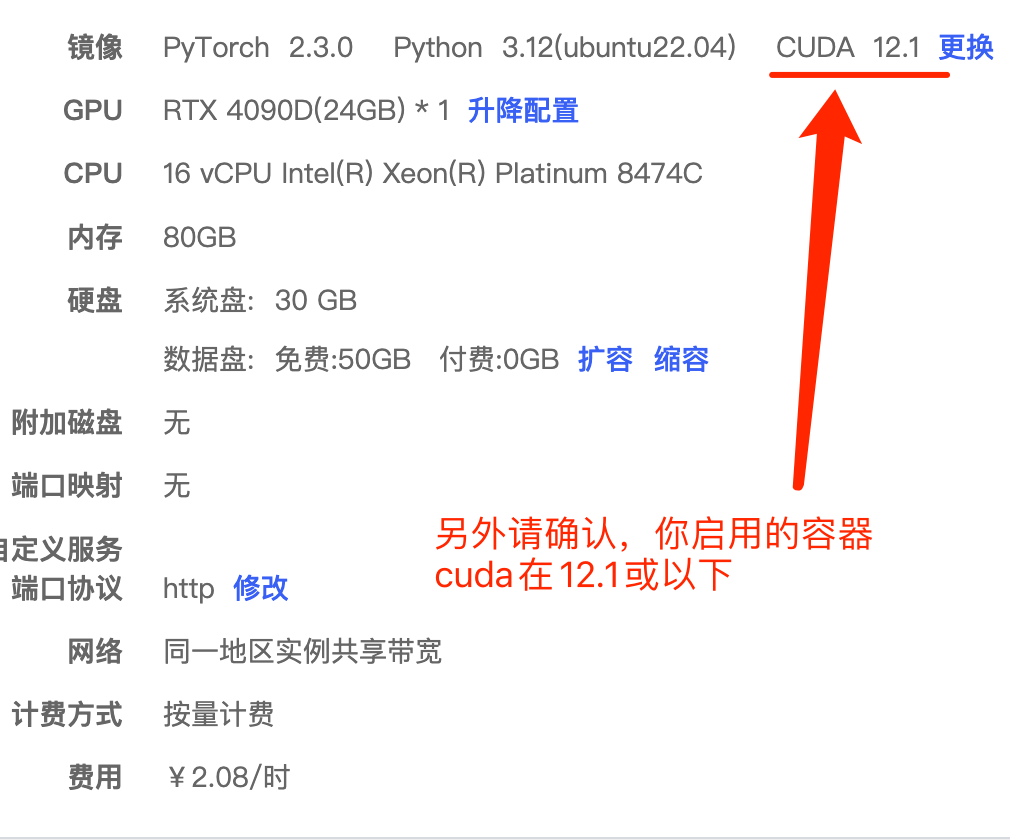

requirements_output.txt发到论坛上,我这边怀疑是您的pytorch版本或者其他依赖包版本和老师的不一样。另外,我看您租用的CUDA版本是11.4,请确保CUDA在11.8以上或者12.1都可以。