第6期课程 31-25.3.21-实时网页信息爬取+RAG的实时简报编写 -林辉老师 #776

Labels

No Label

bug

duplicate

enhancement

help wanted

invalid

question

wontfix

No Milestone

No project

No Assignees

2 Participants

Notifications

Due Date

No due date set.

Dependencies

No dependencies set.

Reference: HswOAuth/llm_course#776

Loading…

Reference in New Issue

Block a user

No description provided.

Delete Branch "%!s()"

Deleting a branch is permanent. Although the deleted branch may continue to exist for a short time before it actually gets removed, it CANNOT be undone in most cases. Continue?

老师好,我想用下 qwen-2-vl-instruct 多模态模型识别图片文字 模拟你上课讲的,图1是我的,图2是你上课我的截图

有两个问题:

1.我fastgpt 没法上传图片,这是我版本的问题吗?

2.我这两个模型图标不一样,是什么原因呢?

3.我在autodl上租用服务器,下载m3e-large模型,总报这个错:

Server error: 400 - [address=0.0.0.0:17556, pid=5239] Model m3e-large cannot be run on engine .

老师,xinference日志报错,autodl机器配置如下,见附件

xinference 安装步骤如下:

vim ~/.bashrc

设置huggingface⽹站镜像

export HF_HOME=/root/autodl-tmp/huggingface-cache/

export HF_ENDPOINT=https://hf-mirror.com

source ~/.bashrc

pip install "xinference[transformers]"

pip install -U huggingface_hub

xinference-local --host 0.0.0.0 --port 9997

打通隧道后在autodl页面 自定义服务打开页面

粘贴过来网址:以下为模板,修改端口和主机名

ssh -p 49746 root@connect.nmb2.seetacloud.com -L 0.0.0.0:9997:0.0.0.0:9997 -N

ssh -CNg -L 6006:127.0.0.1:6006 root@connect.nmb2.seetacloud.com -p 49746

ssh -p 37973 root@connect.nmb2.seetacloud.com -L 0.0.0.0:9997:0.0.0.0:9997 -N

ssh -CNg -L 6006:127.0.0.1:6006 root@connect.nmb2.seetacloud.com -p 37973

打开cmd,输入修改完的网址,输入密码

无报错后,在浏览器输入网址:http://localhost:9997

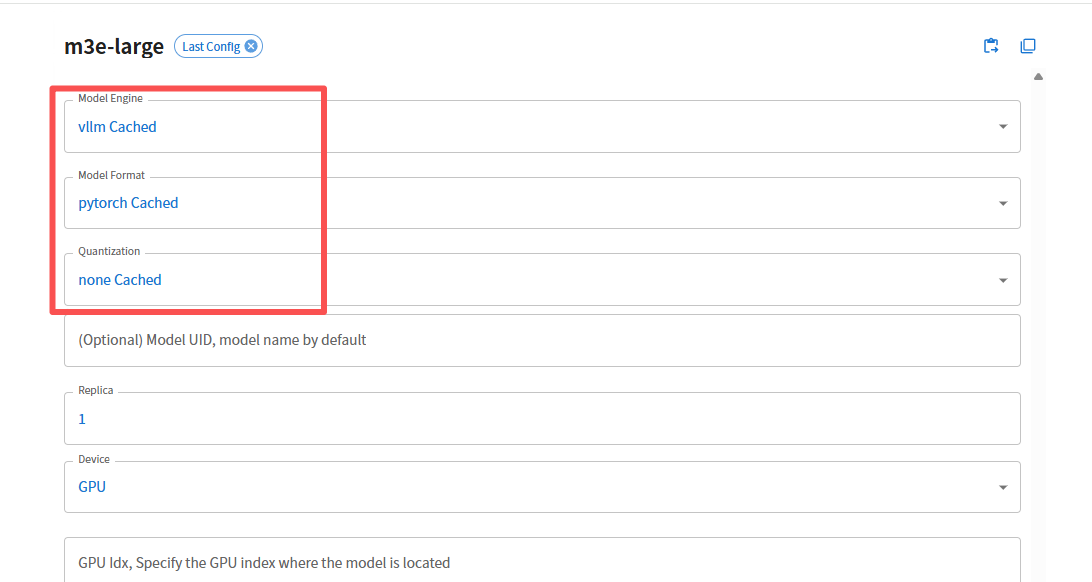

这是因为m3e-large模型不支持transformers引擎,重新按照如下命令xinference即可:

conda install -c conda-forge pynini==2.1.5

pip install cython

pip install "xinference[all]"

然后在xinference界面用如下配置:

老师,我按你上边说的重新部署了一下xinference,现在又报这个错

报错日志里面显示你没有安装torch,先安装下 torch

老师,我重装torch了(2.7.1和2.8.0都试过),还是报那个错,安装torch时,也报错了,如下所示:

pip install torch==2.5.1 torchvision==0.20.1 torchaudio==2.5.1 --index-url https://download.pytorch.org/whl/cu124

使用这个命令安装torch

老师,我用这个安装完,再安装xinference还是报那个错,我再安装其他版本,也报错了,安不了2.7.1

2.6.0也安装不了

你首先卸载掉已经安装的torch:

pip uninstall torch

pip uninstall torchvision

pip uninstall torchaudio

然后用下面的命令安装torch:

pip install torch==2.5.1 torchvision==0.20.1 torchaudio==2.5.1 --index-url https://download.pytorch.org/whl/cu124

最后用下面的命令安装xinfrence:

conda install -c conda-forge pynini==2.1.5

pip install cython

pip install "xinference[all]"

老师,我重新租了太机器,试了一边,还是报这个错

你给一个todesk或者向日葵的远程给我,我远程看一下

向日葵 336495962

老师,现在又出这个问题了

你可以看下报错, ,这个报错说明你的服务器显卡显存不足,有可能是你起了多个实例,没有释放,也有可能是你的其它模型占了显存,你可以先释放下其它模型,或者租一台显存容量更大的服务器

,这个报错说明你的服务器显卡显存不足,有可能是你起了多个实例,没有释放,也有可能是你的其它模型占了显存,你可以先释放下其它模型,或者租一台显存容量更大的服务器