【作业】使用中文数据微调code-llama,并测试效果 #36

Loading…

Reference in New Issue

Block a user

No description provided.

Delete Branch "%!s()"

Deleting a branch is permanent. Although the deleted branch may continue to exist for a short time before it actually gets removed, it CANNOT be undone in most cases. Continue?

中文数据微调code-llama并接入fastgpt

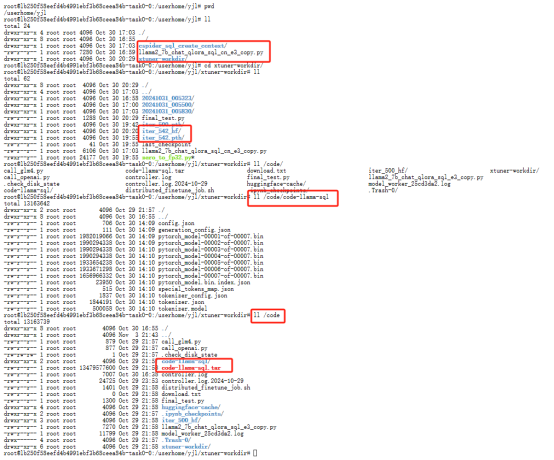

训练模型

模型训练后,打包tar

Xinferece部署微调模型

通过autodl安装Xinferece,登录autodl实例后,打开终端

wget下载模型并解tar包

安装xinference

pip install "xinference[all]"

启动xinference

xinference-local --host 0.0.0.0 --port 9997

本机配置隧道,目的是从本机访问Xinference

ssh -CNgv -L 9997:127.0.0.1:9997 root@connect.yza1.seetacloud.com -p 25266

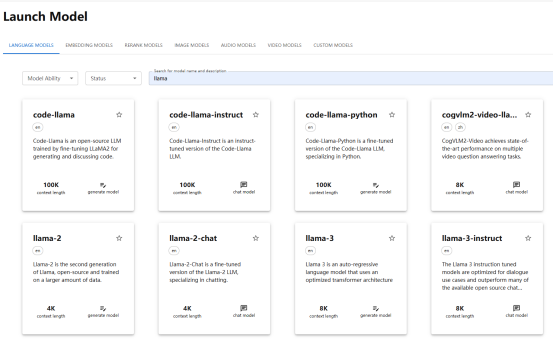

打开Xinference UI

http://127.0.0.1:9997/

找到code-llama-instruce

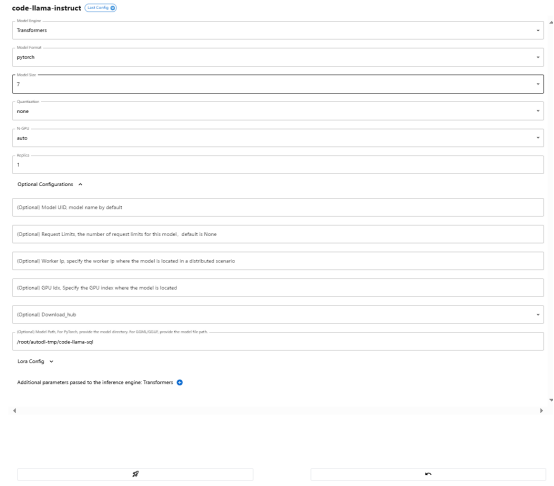

code-llama-instruct配置并启动

FASTGPT部署

租用腾讯云服务器,选择Ubuntu镜像、磁盘30G即可、配置登录密码,其余默认即可

登录云服务器

切换root,避免一些权限问题

sudo su

创建并进入个人目录

mkdir -p /yjl1/fastgpt && cd /yjl/fastgpt

创建文件docker-compose.yml

创建配置文件config.json

更新apt,安装docker-compose

启动容器服务,包括fastgpt、oneapi等

docker-compose up -d

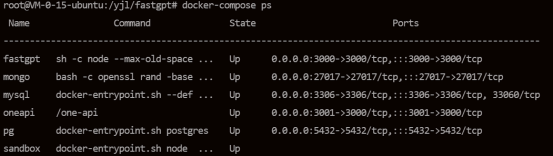

查看服务启动状态

docker-compose ps

由于云服务器默认不开放以上端口,需要配置安全组策略才可以在本机访问

在安全组规则中,直接配置,所有协议端口,本机ip可访问

通过 {服务器公网ip}:3001,打开oneapi页面

默认账号密码为 root/123456,登录后修改密码

点击渠道->添加新的渠道

配置安全组

需要允许服务器访问自己的9997端口,配置如下

在云服务器上建立隧道,目的是将请求转到autodl上的Xinference

ssh -CNgv -L 9997:127.0.0.1:9997 root@connect.yza1.seetacloud.com -p 25266

通过 {服务器公网ip}:3000,打开fastgpt页面,root/1234

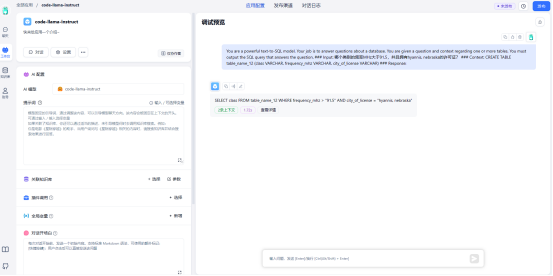

新建简易机器人 code-llama-instruct

AI配置,模型选择code-llama-instruct

输入对话,其中Input是中文,得到结果