大模型04期使用xtuner微调开源大模型--基础版作业 #43

Loading…

Reference in New Issue

Block a user

No description provided.

Delete Branch "%!s()"

Deleting a branch is permanent. Although the deleted branch may continue to exist for a short time before it actually gets removed, it CANNOT be undone in most cases. Continue?

一、作业要求

1.【基础】使用xtuner 内置的yi_6b_qlora_alpaca_enzh_e3进行微调

二、作业过程

1、通过xtuner copy-cfg yi_6b_qlora_alpaca_enzh_e3 将配置文件下载到云服务器/code 目录下

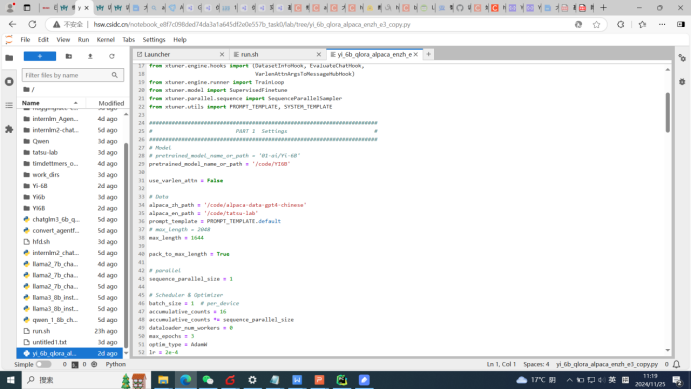

2、查看 yi_6b_qlora_alpaca_enzh_e3.py 文件,下载对应的大模型和两个数据文件。详见附图1

这里有个小问题,通过教材的命令huggingface-cli download 下载大模型经常超时 ,最大的模型文件有10G大小,后来通过modelscope下载成功,速度比较快。

3、修改配置文件,主要是模型和数据目录要修改,并且要将量化配置注释掉,然后通过notebook 进行微调训练,成功。命令为:NPROC_PER_NODE=4 xtuner train /code/yi_6b_qlora_alpaca_enzh_e3_copy.py --work-dir /userhome/xtuner-workdir --deepspeed deepspeed_zero3。 这里关键是量化配置注释时要注意,原来的 “),” 不能被注释,否则训练报错。配置文件详见附图2

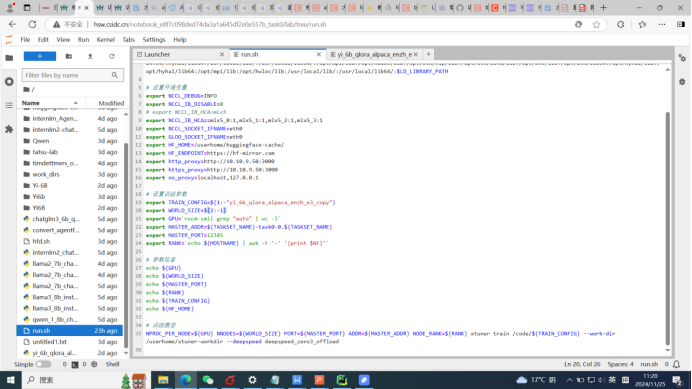

4、修改run.sh 通过bash run.sh yi_6b_qlora_alpaca_enzh_e3_copy.py 进行验证,也成功。

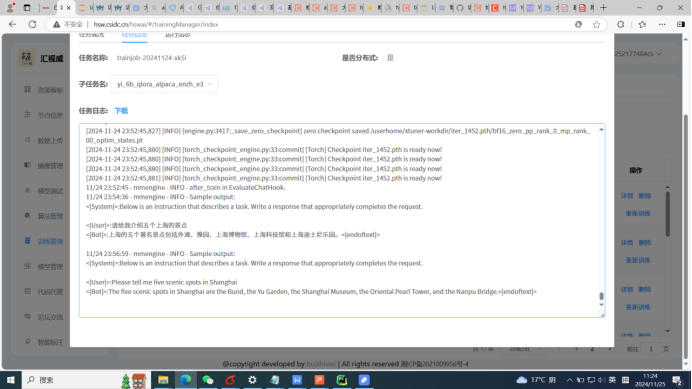

5、创建微调任务进行微调训练,结果发现失败,老师解答是通过微调训练,HF_HOME 环境变量要设置到/userhome下,与notebook时不同。详见附图3

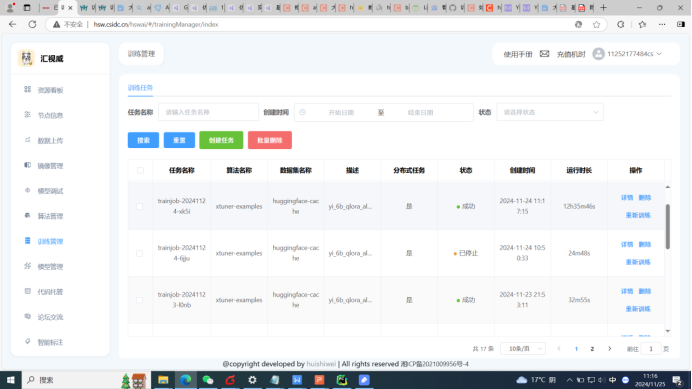

6、重新修改HF_HOME配置后进行微调训练,成功。4个4 DCU节点,一共跑了约13小时。

三、心得体会

作业过程遇到问题不少,耗时比较多,不过能够让自己真正理解大模型的一些过程和逻辑,还是值得的。