【作业贴】2025-02-07,19-大模型初探-基于LLaMA-Factory的模型微调训练 #72

Loading…

Reference in New Issue

Block a user

No description provided.

Delete Branch "%!s()"

Deleting a branch is permanent. Although the deleted branch may continue to exist for a short time before it actually gets removed, it CANNOT be undone in most cases. Continue?

具体实现步骤及结果:

1、下载LLaMA-Factory并解压:

wget https://file.huishiwei.top/LLaMA-Factory.tar.gz

tar -xvf LLaMA-Factory.tar.gz

2、创建虚拟环境

conda create -n llama_factory python=3.11 pip -y

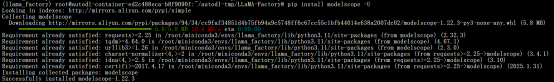

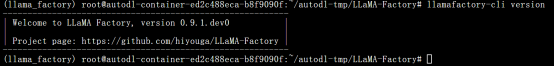

3、安装llama-factory及modelscope

pip install -e ".[torch,metrics] "

pip install modelscope -U

4、安装相关依赖包,验证安装成功

pip install -r requirements.txt

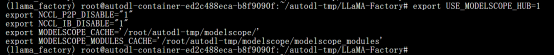

5、设置环境变量

export USE_MODELSCOPE_HUB=1

export NCCL_P2P_DISABLE="1"

export NCCL_IB_DISABLE="1"

export MODELSCOPE_CACHE='/root/autodl-tmp/modelscope/'

export MODELSCOPE_MODULES_CACHE='/root/autodl-tmp/modelscope/modelscope_modules'

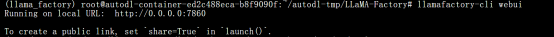

6、启动界面

llamafactory-cli webui

7、打通隧道

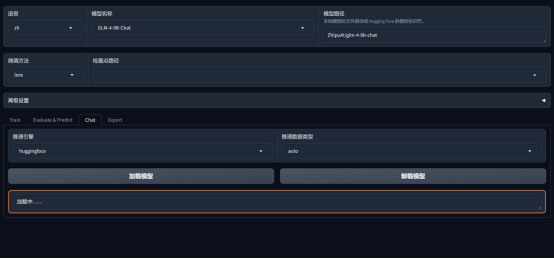

8、加载模型

GLM-4-9B-Chat

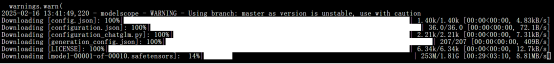

后台等待模型自动下载。

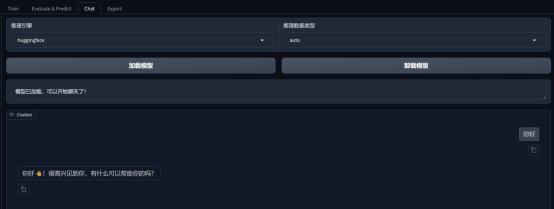

9、可以使用基座模型正常Chat

10、创建微调数据集

my_demo.json

格式为:

{

"instruction": "你好",

"input": "",

"output": "您好,我是 AI易集运智能助手,一个由 鹏海运团队 开发的 AI 助手,很高兴认识您。请问我能为您做些什么?"

},

11、更新数据集配置文件

增加数据集my_demo.json文件

12、使⽤LLaMA-Factory微调模型

不启用量化时显存占用较高

13、启用8比特量化,再次微调

量化后训练完毕:

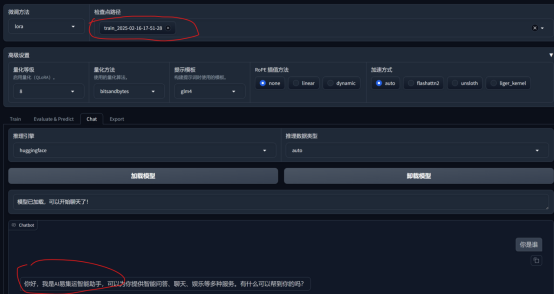

14、再次加载微调后的模型

可以得到微调后的结果: